AI의 발전 방향성과 AI 규제에 대한 고찰

1. AI principle 만들기 (Algorithmic Bias / Disinformation 등을 어떻게 줄이고 극복할 수 있는가?) Google, Microsoft, OpenAI 등등 현재 IT의 최전선을 달리고 있는 기업들은 각 사에서 제 정한 AI principle이 존재한다. 또한 국제 기구 중 최고의 권위를 갖고 있는 OECD에서도 A...

1. AI principle 만들기 (Algorithmic Bias / Disinformation 등을 어떻게 줄이고 극복할 수 있는가?) Google, Microsoft, OpenAI 등등 현재 IT의 최전선을 달리고 있는 기업들은 각 사에서 제 정한 AI principle이 존재한다. 또한 국제 기구 중 최고의 권위를 갖고 있는 OECD에서도 A...

투빅스 19&20기 컨퍼런스 : RAG를 이용한 “투빅이 가이드 챗봇” 후기 0. Introduction 23년 7월부터 20기로 활동을 시작한 대학생&대학원생 인공지능 및 빅데이터 대표 연합 동아리 투빅스에서 19&20기 컨퍼런스로 NLP 팀에서 프로젝트를 진행하였다. 이 게시글은 컨퍼런스 프로젝트에 대한 리뷰 및 설명하려...

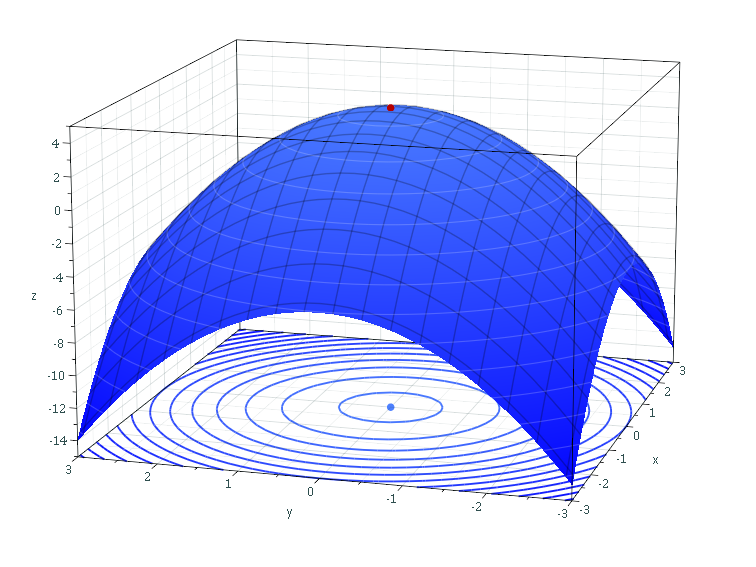

최적화(Optimization) & 경사하강(Gradient Descent)에 대한 정리 이 게시글은 딥러닝을 위한 선형대수학 저서의 6장. 최적화 파트를 정리한 내용과, 추가적으로 정리한 내용으로 만들어졌습니다. 0. 최적화(Optimization) ML, DL 분야에선 모델의 목적함수(Objective Function)인 손실 함수(L...

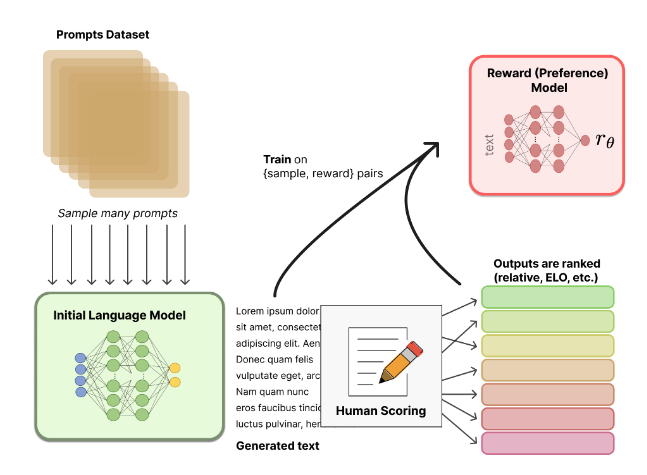

Instruction fine-tuning, Reinforcement Learning from Human Feedback(RLHF) Upload: Proceeding… ** 이 게시글은 아직 제작 과정 중에 있습니다! 내용이 부실하더라도 감안하여 주세요! https://youtu.be/SXpJ9EmG3s4?si=73A2nJoUpjFW5sqC 본...

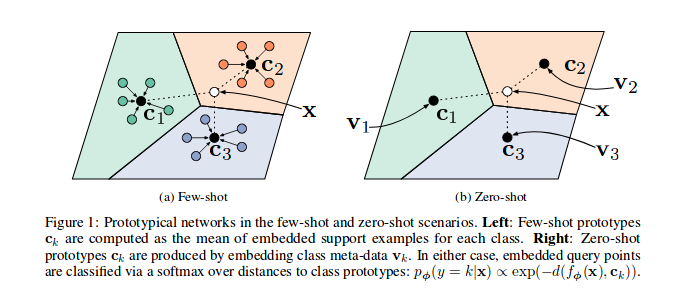

Zero-shot Learning & Few-shot Learning, Chain-of-thought 본 게시글은 2023년도 스탠포드 강의 CS224n의 lecture 11 -prompting, rlhf의 내용을 정리한 게시글입니다. 0. Introduction 0-1. Larger and Larger models 현재 개발되고 있는 ...

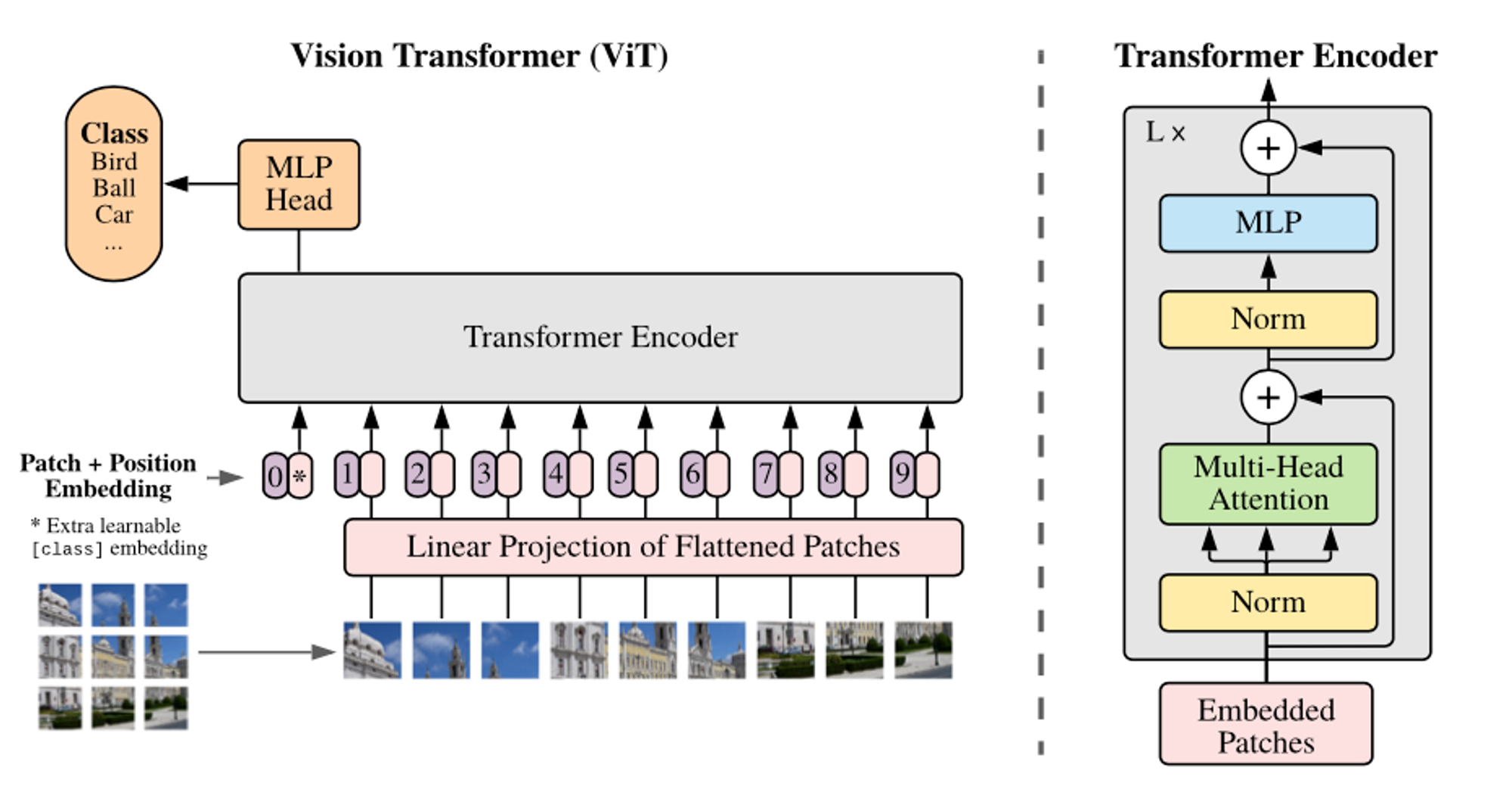

Vision Transformer(ViT) 논문리뷰 1. 개요 Transformer 모델의 등장 이전, RNN은 오랜 시간동안 NLP(Natural Language Processing) 분야에서 기본 모델로써 활용되었다. Attention is all you need : Transformer 모델의 등장으로 인해 NLP 분야에서 RNN의 시대 종...

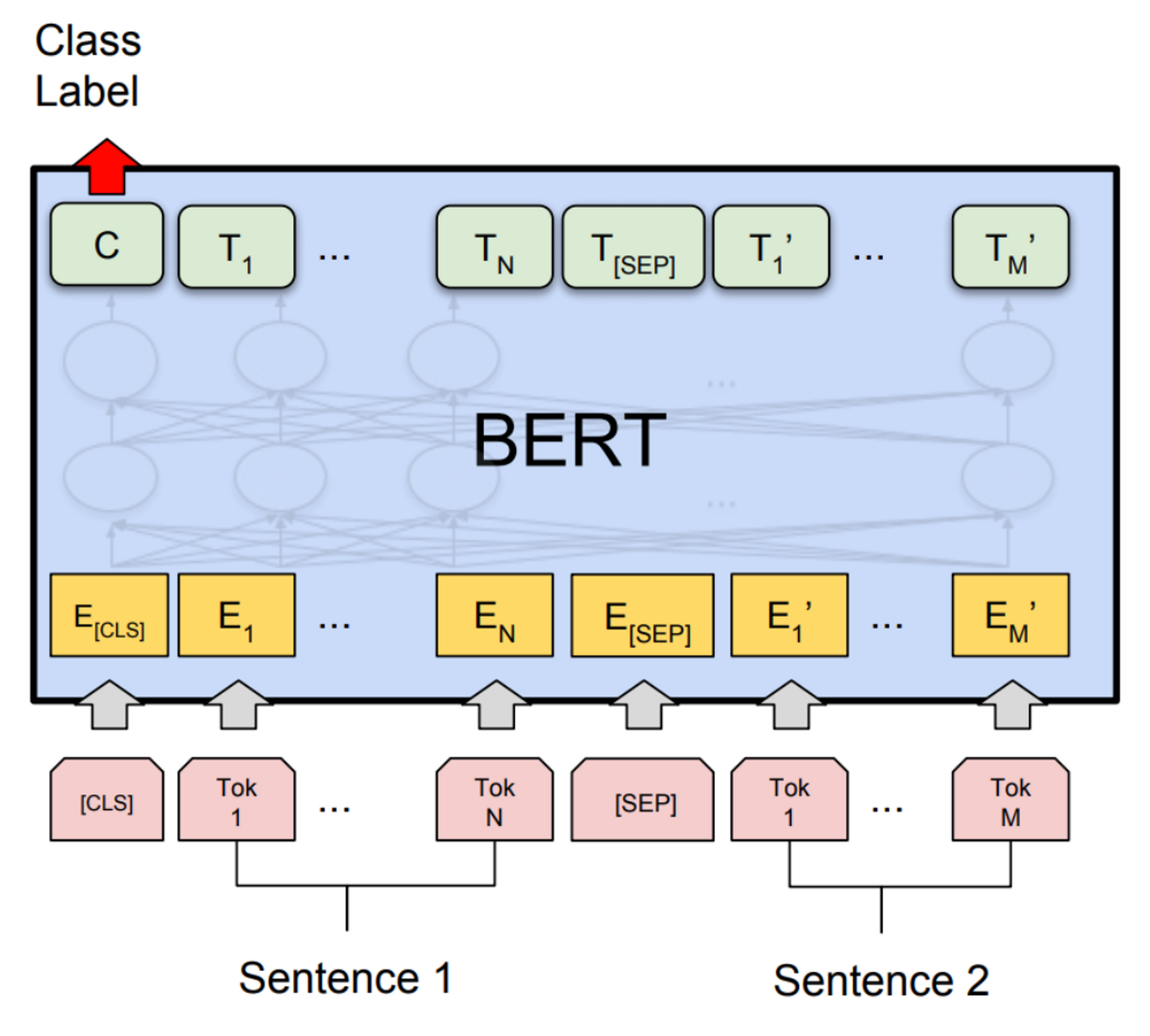

BERT 논문리뷰 1. 개요 Language Model(LM)의 pre-training 방법은 기존의 많은 NLP 태스크에서 효율적으로 개선되어 굉장히 좋은 성능을 내고 있다. 이는 특히 전체적인 sentenct(문장) 간의 관계를 예측하는 sentence(문장) 단위 레벨의 태스크(ex. Nature Language Inference)를 목표하...

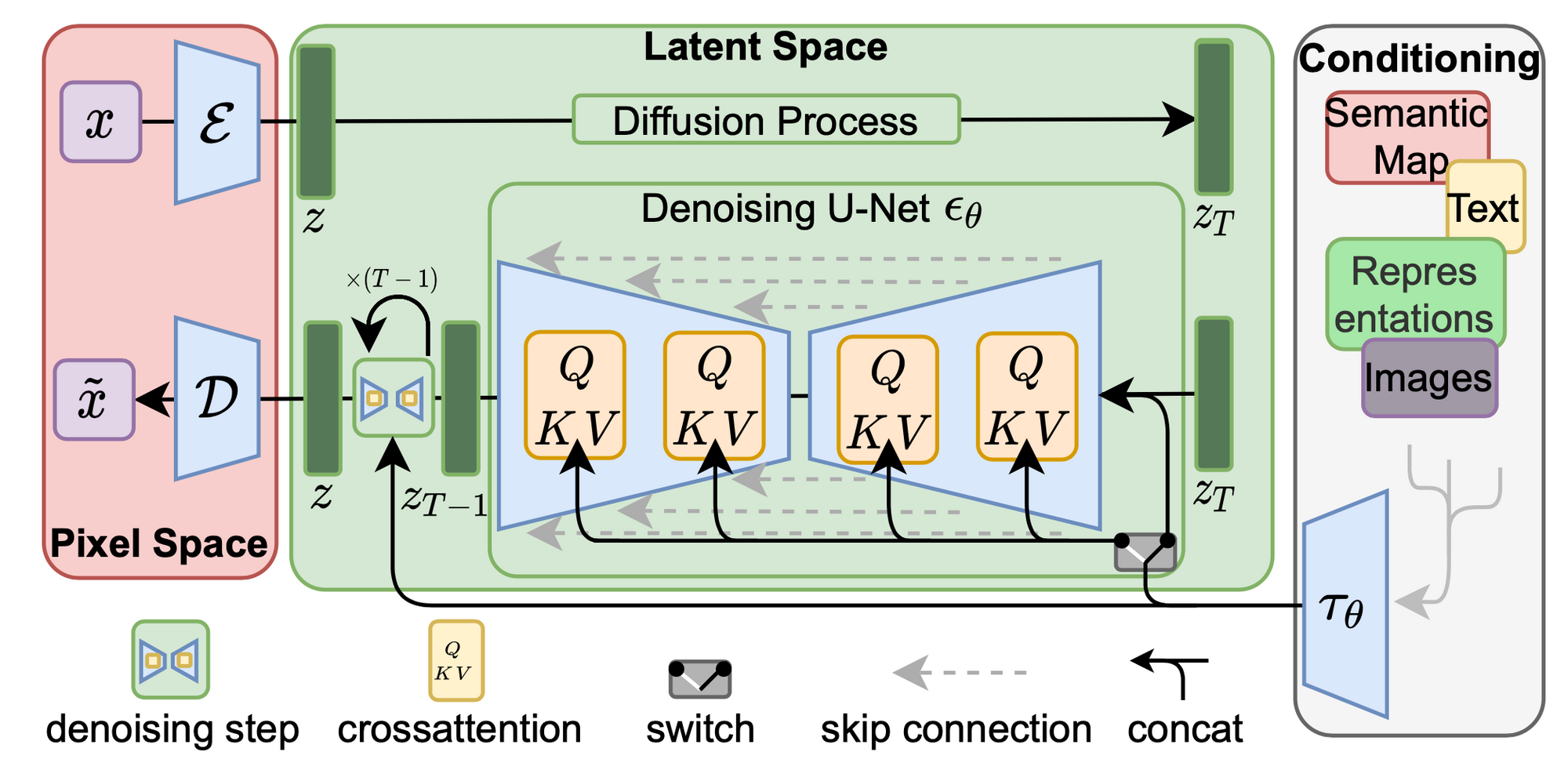

High-Resolution Image Synthesis with Latent Diffusion Models (Stable diffusion) 논문리뷰 1. Introduction 이미지 합성은 엄청난 계산적 요구가 필요함에도 불구하고, 컴퓨터 비전 분야에 있어서 가장 많은 발전을 이룩한 주제이다. 특히 요즘들어 고해상도의 복잡하며 자연스러운 장...

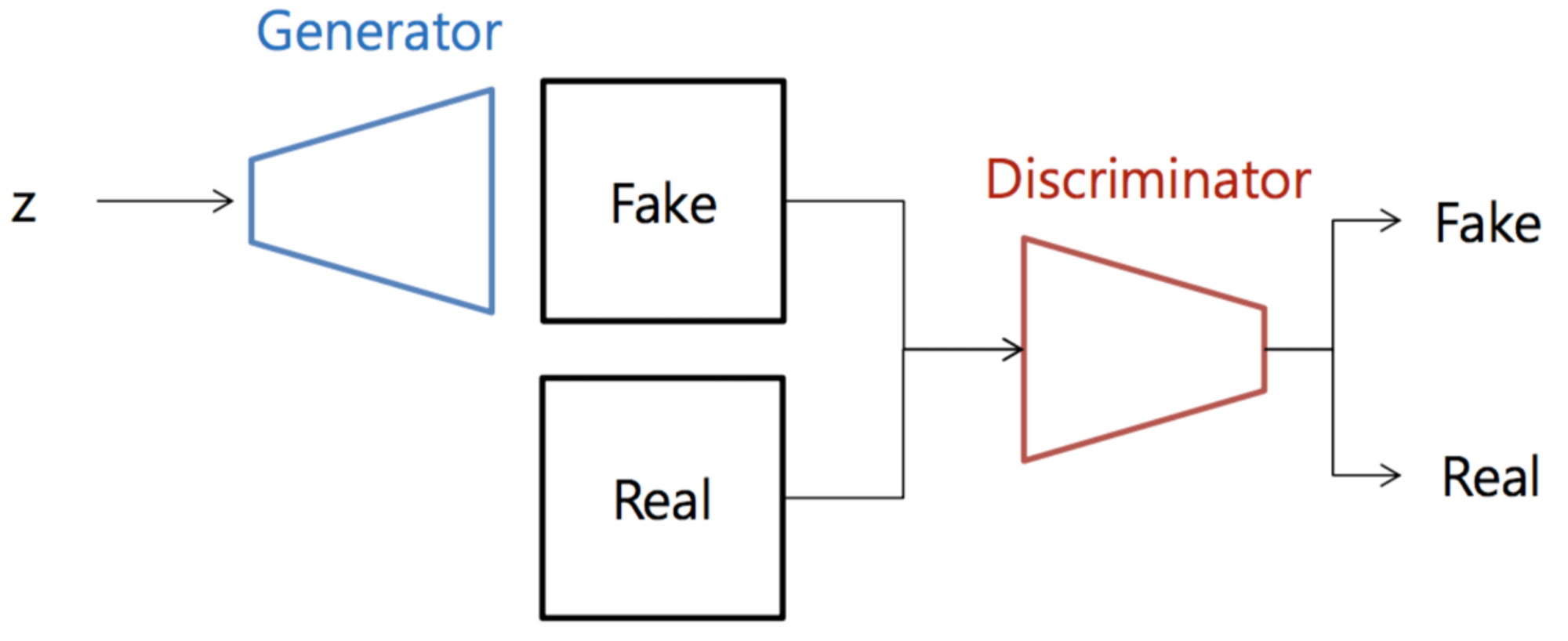

GAN (Generative Adversarial Networks) 논문 리뷰 & How to evaluate GANs? 0. 이미지 데이터의 확률 분포와 생성 모델 이미지 데이터는 벡터나 행렬과 같은 데이터의 형태로 표현하여 컴퓨터가 연산을 진행할 수 있다. 이미지 데이터는 일반적인 일차원 데이터와 달리 RGB와 같은 여러 개의 채널로 이...

앙상블 정리 0. 단일 모델의 한계 결정 트리는 이해하고 해석하기 쉬우며, 사용하기 편하고, 여러 용도로 사용할 수 있으며, 성능도 뛰어나다. 이런 결정 트리는 데이터의 축에 수직으로 분할하는 것을 기반으로 학습을 진행하기 때문에 항상 계단 모양의 결정 경계를 생성한다. 수직으로 분할한다는 특성 상, 결정 트리의 훈련 세트의 회전이 진행되면...

How to Read a Paper (번역) 221216 original paper : https://www.academia.edu/37525767/How_to_Read_a_Paper 제대로된 연구를 시작하기 전, 꽤 유명한 논문인 ‘논문을 보다 효율적이면서 제대로 읽기 위한 가이드를 제시하는 논문’을 번역해보았다. (논문을 읽기 위한 논문 ㅋㅋ...